“La televisione fa bene ai poveri e fa male ai ricchi,[…] e Internet, fa bene ai ricchi e fa male ai poveri". Con queste parole Umberto Eco, in una nota intervista di qualche anno fa, descriveva il diverso impatto di due dei mass media i punta, Tv e web, su le due categorie “poveri” e “ricchi”, da intendersi non in senso patrimoniale, ma culturale e d’istruzione. Infatti, la tv ha insegnato molto a chi non aveva accesso a determinati livelli d’istruzione (il maestro Manzi docet), e, nonostante tutto, presenta un controllo qualitativo molto più puntuale, rispetto al liberi tutti del web, in cui i “poveri” si trovano in balia delle onde di un oceano di notizie e dati. Al contrario, i “ricchi” (in spirito, potremmo dire) sono stati svantaggiati dalla tv che lì ha resi più pigri e votati all’omologazione, ma al contempo riescono a trarre beneficio da internet, possedendo la capacità critica e di discernimento, essenziali per filtrare, selezionare e districarsi nel mare magnum del web.

Questo acuta osservazione del Prof. Eco è oggi quanto mai vera, e allo stesso tempo ulteriormente complicata per entrambe le categorie in oggetto, dalla stessa evoluzione del web, in cui, nella stregua di miliardi di terabyte di big data, vi si trovano disseminate “trappole” in termini di bufale, fake news e disinformazioni di sorta, difficilmente smascherabili anche per i cosiddetti “ricchi”. Non è un caso che di pari passo alla pandemia, quest’anno si sia assistito anche ad una vera propria infodemia a colpi di algoritmi e filter bubbles.

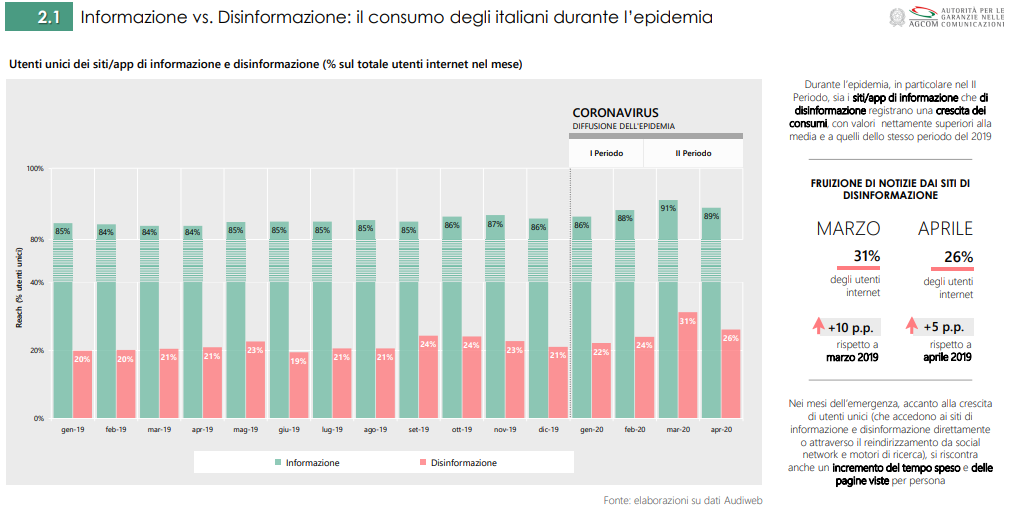

Come emerge dall'Osservatorio AGCOM sulla disinformazione online pubblicato nel giugno 2020, durante la prima fase dell’emergenza sanitaria, sia i siti/app di informazione che di disinformazione registrano una crescita dei consumi, con valori nettamente superiori alla media e a quelli dello stesso periodo del 2019 (+ 10 punti percentuale solo a marzo 2020).

In questo scenario, i veri protagonisti che non possono più ignorare l’elefante nella stanza sono le big tech. Il loro ruolo è sempre controverso, ed è ancora lungi dall’essere chiara le direzione ottimale con cui procedere nei fatti. All’inizio il non voler essere “editori” li legittimava a non assumersi responsabilità di sorta sui contenuti che potevano così raggiungere miliardi di persone, indipendentemente da tutto. Questi ultimi anni (e alcuni fatti clamorosi avallati dal web, si pensi a Brexit o a diverse altre ingerenze in diverse elezioni, oltre che alla diffusione di immagini e video eticamente e moralmente deprecabili) hanno reso evidente che lasciare queste piattaforme a briglie sciolte non è possibile. In tal senso, sono altresì discutibili le decisioni prese da alcuni grandi social media sulla censura dei profili dell’ex presidente USA, Donald Trump, a riprova di quanto spinosa sia la questione.

Come sottolinea Will Media nella sua newsletter Loop dello scorso venerdì 22 gennaio 2021, nel mondo oggi, per far fronte alla necessità di moderazione dei contenuti online, ci sono migliaia di persone pagate per guardare contenuti postati sui social o su YouTube in 50 lingue (e molti di questi lavoratori, a causa della mole degli stessi contenuti che si trovano a censurare, sentono di essere sempre più soggetti a disturbi da stress post-traumatico).

Un’ulteriore passo in tal senso è intrapreso da Big G.: Google ha aperto un nuovo centro europeo, con sede a Dublino, per contrastare i contenuti dannosi o illegali, nello spirito del loro vecchio motto “Don’t be evil”.

Nello specifico, la creazione di un nuovo Google Safety Engineering Center (GSEC), segue l’apertura del GSEC di Monaco di Baviera inaugurato nel 2019 e dedicato alla privacy e alla sicurezza degli utenti. Il nuovo GSEC sarà votato ad affrontare le tematiche legate alla responsabilità dei contenuti. Dalla presentazione offerta da Google, questo nuovo centro vuole essere un punto di riferimento a livello europeo per gli esperti di Google impegnati nel contrasto alla diffusione di contenuti illegali e dannosi, e un luogo in cui condividere questo lavoro con i policymaker, i ricercatori e le autorità regolamentari.

Questo GSEC vuole apparentemente fare parte di una più comprensiva operazione di trasparenza, aiutando a comprendere come Google sviluppi e applichi le sue policy, il funzionamento delle sue tecnologie anti-abuso e dei sistemi di rilevamento di potenziali minacce; oltre al modo in cui collabora con le organizzazioni specializzate nel segnalare contenuti che violano le norme, i suoi processi di gestione degli eventi problematici e le pratiche di moderazione dei contenuti.

Nello specifico, Google identifica tre aree d’interesse, che vengono dallo stesso così dettagliate:

- “Autorità regolamentari: attraverso il nuovo GSEC, le autorità regolamentari saranno in grado di accedere a maggiori informazioni sul funzionamento pratico dei nostri sistemi di moderazione dei contenuti e di altre tecnologie, in un luogo sicuro che salvaguardi la riservatezza delle informazioni degli utenti. Quando sarà pienamente operativo, il centro consentirà alle autorità regolamentari e ai policymaker (nell'ambito di quadri giuridici esistenti o futuri, come il Digital Services Act) di condurre indagini, valutare i processi e procedere ad accertamenti ufficiali.

- Accademici: il GSEC di Dublino lavorerà con la comunità accademica e le organizzazioni che promuovono la sicurezza online. Grazie a questo nuovo centro saremo in grado di rafforzare il nostro impegno verso i ricercatori, le organizzazioni non profit e altre realtà interessate, in merito ai rischi emergenti e alle nuove tendenze per migliorare la sicurezza online, un lavoro che sarà svolto con le adeguate garanzie di riservatezza, privacy e sicurezza per gli utenti.

- Società: il nuovo GSEC si inserisce in un quadro più ampio di iniziative che costituiscono il nostro approccio di “responsabilità integrata”. Condivideremo le nostre conoscenze in modo più ampio attraverso la pubblicazione di rapporti e approfondimenti sui temi legati alla responsabilità dei contenuti. Abbiamo già cominciato a lavorare in questa direzione pubblicando un white paper su moderazione dei contenuti e qualità delle informazioni”.

Il punto della “responsabilità integrata” è sicuramente quello su cui dovranno sempre più convergere gli sforzi di big tech, istituzioni e società civile, e che non è più rimandabile alla “buona volontà” di alcuni, per cui molto spesso si assiste pressoché passivi a bufale, fenomeni di dogmatismo antiscientifico, se non a veri e propri crimini e violenze.